Чому ШІ може бути упередженим: простими словами про складне

Штучний інтелект щодня стає ближчим до нас — у смартфоні, у банку, у лікарні. Він обіцяє швидші рішення, персоналізацію і ефективність. Але іноді ці системи приймають несправедливі або дивні рішення: від неправдивих відмов у кредиті до хибних діагнозів. Чому так відбувається? Що таке упередженість у ШІ і як з нею боротися? У цій статті простими словами і з практичними кроками розберемося в причинах, вимірюванні та пом’якшенні біасу у ШІ, а також у ролі етики AI й AI регулювання.

Що таке упередженість і біас у ШІ: просте визначення

Почнемо з термінології. Коли ми говоримо про упередженість у ШІ (інколи використовують англомовний термін bias), маємо на увазі систематичні помилки або нерівне ставлення моделі до різних груп людей чи ситуацій. Це не обов’язково “злонамірений” код — частіше це результат людських рішень, даних і контексту.

Типи упередженості

- Дані: історичні або зібрані дані можуть відображати нерівність. Наприклад, якщо в даних менше прикладів певної групи, модель працюватиме гірше для неї.

- Алгоритмічна упередженість: вибір архітектури, метрик оптимізації й гіперпараметрів може посилювати нерівності.

- Операційна/контекстна: модель, що працює в одному середовищі, може бути непридатна в іншому — те, що “чесно” у тренувальних умовах, може бути упередженим у реальному світі.

- Суб’єктивні рішення людей: як маркують дані, які інструкції дають моделі, хто оцінює результати — все це впливає.

Усе це разом і формує біас у ШІ. Важливо: не кожна різниця у результатах — це упередженість у етичному сенсі. Іноді різниця пояснюється релевантними факторами. Завдання — розпізнати, коли відмінності є несправедливими і шкідливими.

Чому виникає упередженість: розбираємося в причинах

Розглянемо джерела проблеми по пунктах. Тут не лише техніка — це комбінація людей, бізнес-моделей і суспільства.

1. Неповні або нерепрезентативні дані

Якщо у вас 95% прикладів з однієї групи, модель просто не навчиться розуміти іншу. Наприклад, системи розпізнавання облич часто гірше працювали на темношкірих людях через брак таких даних у тренувальних наборах. Це не дивина: модель “бачить” те, чого навчили.

2. Історичні нерівності в даних

Дані часто відображають історичні упередження: наприклад, якщо раніше жінкам рідше давався кредит, модель може повторити цю закономірність та відмовляти жінкам частіше, навіть без явного врахування статі. Тут проблема — не помилка в математиці, а те, що модель реплікує минуле.

3. Вибір метрик і цілей під час тренування

Оптимізація під середню похибку чи точність загалом може приховувати погані результати для меншин. Якщо бізнес орієнтується на агрегований показник, проблеми для окремих груп можуть відсутні в метриці. Чи готові ви пожертвувати трохи середньої продуктивності заради більшої справедливості?

4. Проксі-перемінні й непрямі співпадіння

Часто модель не використовує “чутливу” ознаку напряму, але використовує проксі — наприклад, поштовий індекс може корелювати зі статтю чи расою. Якщо не перевіряти кореляції, несправедливості виникатимуть неусвідомлено.

5. Зворотний зв’язок і цикли посилення

Системи, що приймають рішення, впливають на майбутні дані. Рекомендації чи автоматичні рішення можуть змінити поведінку людей, і це створює петлю, яка ще більше вкорінює упередження. Хочете приклад? Якщо система рідше показує роботу певній групі, ці люди отримають менше шансів, і нові дані підтвердять “погану” ефективність, хоча винен алгоритм.

Найвідоміші приклади упередженості: де боляче і чому це важливо

Кілька конкретних історій допоможуть побачити проблему живою. Чим рельній приклад, тим легше зрозуміти наслідки.

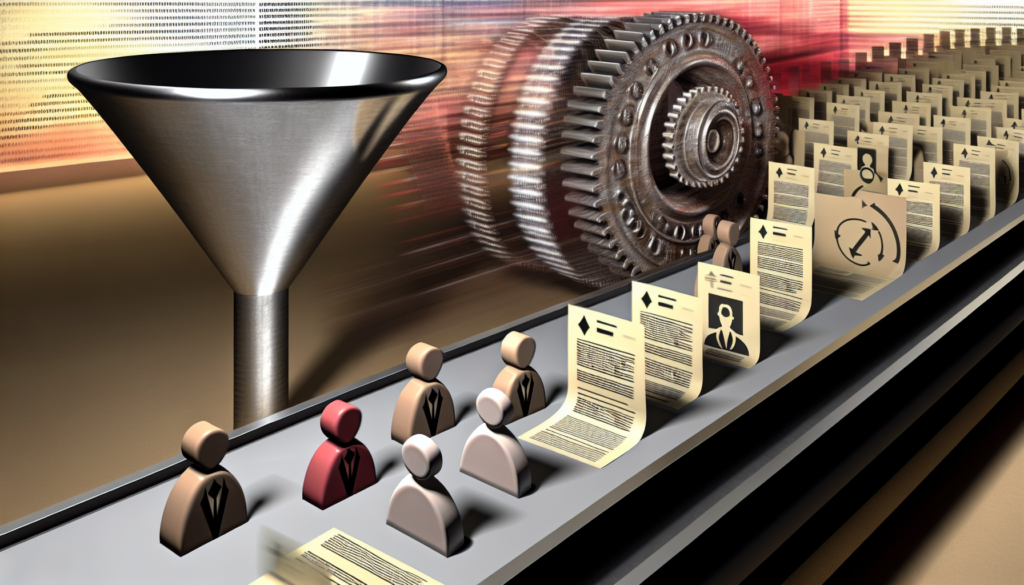

- COMPAS (система оцінки рецидиву): у США алгоритм, що оцінював ймовірність повторного злочину, проявляв вищу помилку щодо чорношкірих підсудних — і це впливало на рішення судів.

- Рекрутингові системи: штучний інтелект, що відкидав резюме жінок через історичні упередження в даних найму.

- Розпізнавання облич: комерційні моделі помилково ідентифікували людей певних етнічних груп частіше, ніж інших.

- Кредитні скорингові моделі: непрямі ознаки призводили до систематичних відмов для певних районів чи спільнот.

Ці приклади демонструють, що наслідки можуть бути серйозними — від помилкових звинувачень до втрати доходу чи доступу до послуг.

Як виявити і виміряти біас у ШІ: методи та метрики

Якщо упередженість не вимірювати, її важко контролювати. Ось перевірені підходи і практичні інструменти для аудиту моделей.

Кроки для початку аудиту

- Визначте, які групи можуть зазнавати несправедливого ставлення (чутливі ознаки: стать, раса, вік, географія тощо).

- Зберіть розподіл виходів моделі по цих групах.

- Порівняйте показники продуктивності для кожної групи.

- Проведіть тестування “на межі”: що відбувається при невеликих змінах в даних?

Корисні метрики fairness

Немає універсальної метрики — кожна підходить для різних випадків. Ось кілька, які варто знати:

| Метрика | Що вимірює | Коли корисна | Обмеження |

| Demographic parity (популяційна паритетність) | Частка позитивних рішень у різних групах | Коли важлива однакова частка доступу до послуги | Ігнорує корисність рішення, може знижувати загальну продуктивність |

| Equal opportunity | Рівень істинно позитивних результатів між групами | Коли важливий однаковий доступ до переваг (напр., діагностика) | Потребує наявності “правди” (ground truth) |

| Equalized odds | Рівні істинно позитивних та хибно позитивних показників | Коли важливі і ризики, і вигоди | Може потребувати компромісів у загальній точності |

| Calibration | Відповідність прогнозованих ймовірностей дійсним ризикам | Коли важлива коректність оцінок ризику/ймовірності | Може бути складною для багатокласових задач |

Коротко: вибір метрики залежить від предметної задачі і цінностей організації. Попросіть зацікавлені сторони пояснити, що вони вважають “справедливим”.

Технічні інструменти та практики

- Моніторинг продуктивності по підгрупах (slice analysis).

- Проведення A/B-тестів з метриками fairness.

- Adversarial testing — створення “злісних” прикладів, які можуть виявити слабкі місця.

- Документація даних: datasheets, model cards, datasheets for datasets.

- Зовнішній аудит і peer review — сторонні експерти бачать те, що пропустили розробники.

Практичні способи зменшити упередженість: поради для розробників і бізнесу

Технічно усунути упередженість повністю складно, але можна значно знизити ризики. Ось конкретні кроки, які можна втілити відразу.

Перед тренуванням: робота з даними

- Плануйте збір даних із урахуванням репрезентації всіх ключових груп.

- Документуйте джерела, умови збору й відомі обмеження.

- Використовуйте методи аугментації і синтетичні приклади, якщо це етично та безпечно.

- Перевіряйте кореляції між ознаками, шукайте проксі-перемінні.

Під час тренування: налаштування та оптимізація

- Використовуйте fairness-aware алгоритми (reweighting, adversarial debiasing).

- Включайте додаткові обмеження у функцію втрат, якщо це виправдано.

- Паралельно оптимізуйте кілька метрик: не лише загальну точність.

Після тренування: пост-обробка і перевірка

- Проводьте постпроцесинг для вирівнювання розподілів рішень між групами.

- Тестуйте на нових, незалежних наборах даних.

- Моніторте модель у продуктивному середовищі: динаміка показників може змінюватися.

Організаційні практики

Технологія — лише частина рішення. Не менш важливо налагодити процес та культуру в компанії:

- Створіть міждисциплінарні команди: інженери, дизайнери, юристи, представники цільових спільнот.

- Визначте відповідальних за етику AI і контроль якості.

- Впровадьте регулярні аудити й “post-mortem” аналізи у випадку інцидентів.

- Навчайте команду поняттям fairness: прості лекції, кейси, воркшопи.

Чекліст для запуску моделі

- Чи були перевірені дані на репрезентативність?

- Чи є документальна інформація про джерела і обмеження наборів даних?

- Які метрики fairness обрані і чому?

- Чи проведено зовнішній аудит або тестування з участю спільнот?

- Чи є механізми моніторингу після релізу?

- Чи передбачено план дій у разі виявлення упередженості в продукції?

AI регулювання і етика AI: що відбувається на рівні політики

Технологія розвивається швидко, і законодавство намагається її наздогнати. Які підходи до AI регулювання існують та що це означає для компаній?

Короткий огляд міжнародних підходів

- GDPR (ЄС) вже визначив права на пояснення і обмеження автоматизованих рішень щодо персональних даних.

- Європейський Союз розробляє комплексний підхід до регулювання ШІ (European AI Act), що класифікує ризики і встановлює вимоги для високоризикових систем. Більше про підхід ЄС можна дізнатися на офіційному сайті Єврокомісії: European approach to AI.

- Інші країни та організації (OECD, UNESCO) пропонують принципи етичної розробки AI — прозорість, справедливість, відповідальність.

Що означає AI регулювання для бізнесу?

Регулювання не лише примус, а й можливість: воно змушує стандартизувати процеси, що знижує ризик шкоди та додає довіри з боку користувачів. Для бізнесу це значить:

- Використовувати практики документування (model cards, datasheets).

- Підвищувати прозорість у комунікації з користувачами щодо обмежень системи.

- Інвестувати в аудит і моніторинг — це економить гроші в довгостроковій перспективі (менше інцидентів, судових спорів, репутаційних втрат).

Етичний дизайн — більше ніж відповідність

Етика AI — це не лише дотримання норм. Це підхід до дизайну, який враховує людей у центрі процесу: хто постраждає від помилок, які альтернативи є у користувача, як дати людині контроль. Вбудована етика робить продукт сильнішим і стійкішим.

Ролі та відповідальності: хто що має робити

Боротьба з упередженістю — командна робота. Ось хто і що може робити у цій екосистемі.

Розробники та інженери

- Робити аналіз даних перед тренуванням.

- Включати метрики fairness у пайплайн CI/CD.

- Документувати рішення і trade-offs.

Продуктові менеджери та дизайнери

- Формулювати задачі з урахуванням етичних ризиків.

- Планувати UX, де користувач має зрозуміти обмеження системи.

- Залучати представників користувачів до тестування.

Юристи і політики

- Пояснювати вимоги регуляторів і формувати політики відповідального використання.

- Допомагати у створенні процедур реагування на інциденти.

Користувачі і громадськість

Громадськість має право знати, як системи впливають на життя. Відкрита комунікація, механізми зворотного зв’язку і участь у тестуванні роблять системи добрішими.

Практичні кейси і вправи: як почати прямо зараз

Не потрібно чекати корпоративної політики або регулювання — почати можна на рівні команди. Ось набір вправ та простих проєктів, які допоможуть навчитися виявляти та знижувати біас.

Вправа 1: Slice analysis за 1 день

- Візьміть ваш набір даних і оберіть одну чутливу ознаку (напр., стать, вік, регіон).

- Розрахуйте ключову метрику (accuracy, ROC-AUC, F1) для кожної підгрупи.

- Знайдіть найгіршу і найкращу підгрупу — які відмінності? Чи прийнятні вони?

Вправа 2: Проксі-перевірка

- Створіть кореляційну матрицю між ознаками та чутливими ознаками.

- Визначте ознаки з високою кореляцією — вони можуть служити проксі.

- Розгляньте видалення або перетворення таких ознак і перевірте вплив на fairness.

Вправа 3: Model card за вихідні

Напишіть коротку модельну картку: для чого модель, які дані використовували, в яких умовах тестували, відомі обмеження. Це допомагає продукувати прозорість і дисципліну в команді.

Ресурси та корисні практики

Де вчитись далі? Ось перевірені джерела і інструменти, які допоможуть розширити практику:

- Книги і курси з етики AI (Coursera, edX) — шукати курси з практичними кейсами.

- Open-source бібліотеки для fairness (AIF360 від IBM, Fairlearn від Microsoft).

- Документи: model cards, datasheets for datasets — приклади можна знайти в відкритому доступі.

- Спільноти практиків: форуми, локальні meetup — обмін досвідом з реальними кейсами.

Якщо хочете прочитати більше про підходи регуляторів та принципи на європейському рівні, перегляньте офіційні матеріали Єврокомісії щодо підходу до ШІ (European approach to AI): https://digital-strategy.ec.europa.eu.

Як це виглядає у бізнесі: короткий практичний план впровадження

План для невеликої компанії, яка хоче ввести етичні практики без великих витрат:

- Місяць 1: Інвентаризація. Зібрати список моделей, де вони застосовуються, і визначити потенційно чутливі зони.

- Місяць 2: Мінімальний аудит. Провести slice analysis і документувати проблемні ділянки.

- Місяць 3: Швидкі виправлення. Впровадити постпроцесінг, reweighting або прості правила для виправлення критичних невідповідностей.

- Місяць 4–6: Політики й моніторинг. Запустити регулярний моніторинг у продукції та сформувати внутрішні правила роботи з даними.

- Далі: зовнішній аудит та робота зі стейкхолдерами.

Чого уникати: поширені помилки при роботі з біасом

Корисно знати, які підходи не працюють або навіть шкодять:

- Імітація fairness через “маскування” проблем — наприклад, видалення ознак без розуміння проксі-проблеми.

- Вирішення однієї метрики за рахунок іншої без оцінки наслідків.

- Ізольована робота технічних команд без залучення представників користувачів і юристів.

- Ігнорування моніторингу після релізу.

Відповіді на типові питання

Чи можна повністю позбутися упередженості?

Ні, неможливо гарантувати повну відсутність упереджень, але можна і потрібно значно їх знизити. Це як охайність: ви не зробите світ ідеальним, але зробите його безпечнішим і передбачуванішим.

Чи впливає відкритість коду на упередженість?

Відкритість не вирішує проблему сама по собі, але вона підвищує шанси на виявлення проблем: більше очей, більше аудиту, більше ідей для виправлення.

Як залучити користувачів у перевірку на справедливість?

Прямі інтерв’ю, фокус-групи, бета-тестування з представниками різних спільнот. Пам’ятайте: користувачі — джерело контекстної інформації, яку не замінить жоден набір даних.

Підсумок: що зробити сьогодні

Якщо вам потрібно тільки кілька конкретних кроків — ось план на завтра:

- Перевірити розподіл даних за однією чутливою ознакою.

- Додати один fairness-метрик у CI-процес.

- Написати коротку model card і опублікувати її для внутрішнього користування.

- Запланувати зустріч з представником юридичного відділу щодо вимог AI регулювання.

Малими кроками ви створите культуру, яка допоможе уникати серйозних помилок і втрат у майбутньому. Якщо хочете більше матеріалів або чеклістів — перегляньте нашу категорію Етика та безпека AI для додаткових гайдів і кейсів.

Упередженість у ШІ — це не магія й не вирок. Це проблемний симптом системи даних, рішень і контексту. Розпізнати його, виміряти і пом’якшити — реально. Почніть зі сміливих маленьких кроків: інвентаризації, документації і простого аудиту по підгрупах. Впроваджуйте практики прозорості, залучайте користувачів і стейкхолдерів, і тоді ваші системи стануть достовірнішими, безпечнішими й чеснішими.